Парсинг сайта может отнимать немало времени, даже если вы работаете через специальные сервисы. Однако многие из них можно адаптировать под собственные задачи с помощью соответствующих настроек. Рассмотрим это на примере сервиса Screaming Frog.

Видеоинструкция

Настраиваем где будут храниться данные сканирования Screaming Frog

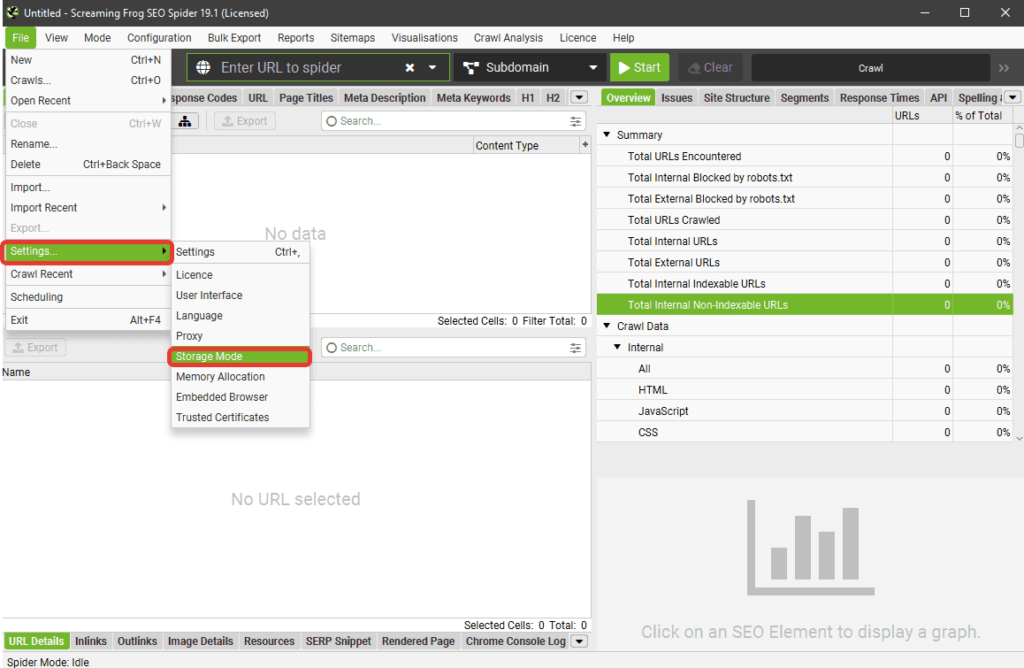

Первое, что нам необходимо – настроить тип хранения данных. Для этого переходим в пункт меню File (Файл) и выбираем пункт Настройки (Settings) в выпадающем списке.

В новом выпадающем списке выбираем Storage Mode (Тип хранения данных). Здесь их два:

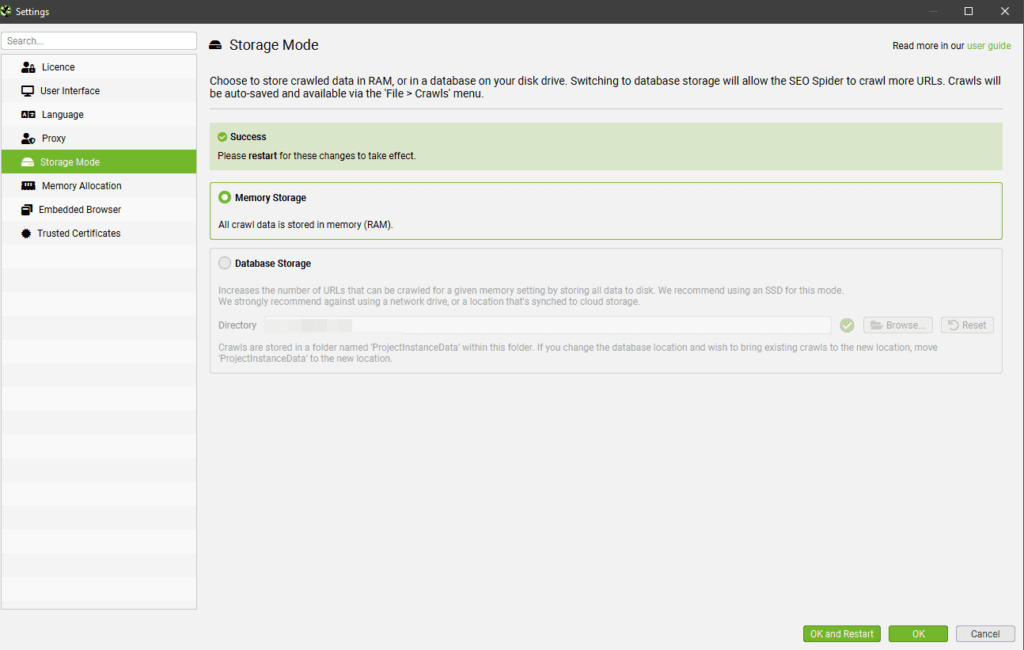

- В оперативной памяти (Memory Storage). При выборе этого режима скачивание происходит быстро, и если оперативной памяти много, а места на жестком диске мало, то он вполне подойдет. Однако для работы с большим сайтом его может быть недостаточно.

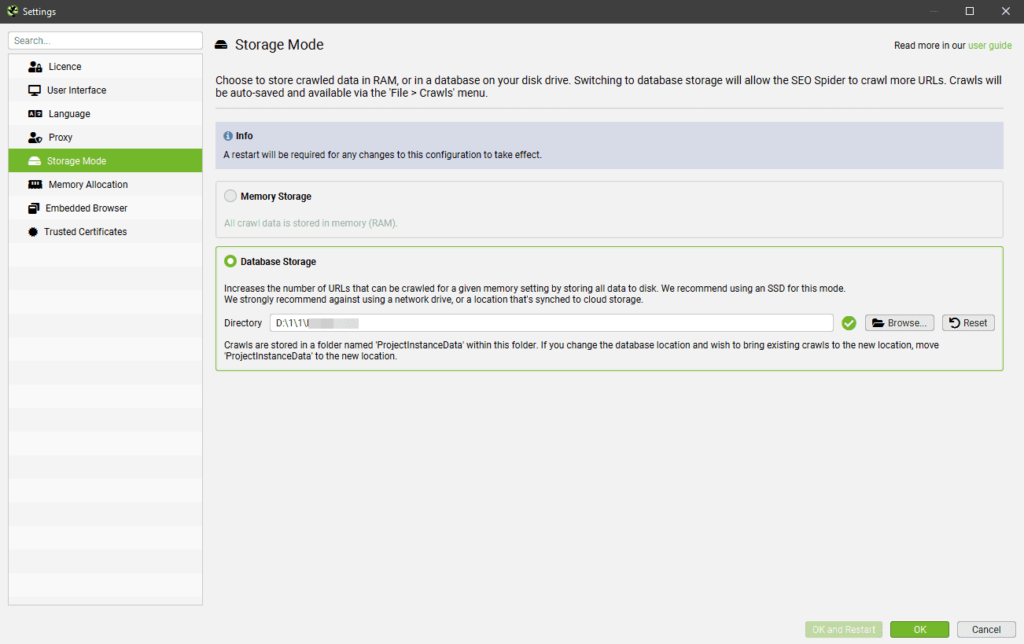

- На жестком диске (Database Storage). Здесь потребуется выбрать путь хранения, где будут размещаться все данные. Однако парсинг в данном случае идет медленнее, а скачиваемые файлы занимают намного больше места, чем при хранении в оперативной памяти.

Далее возвращаемся в пункт Settings и выбираем Memory Allocation. Здесь вы можете установить количество оперативной памяти, которую система может использовать для хранения. Это пригодится, если параллельно вы работаете над чем-то еще.

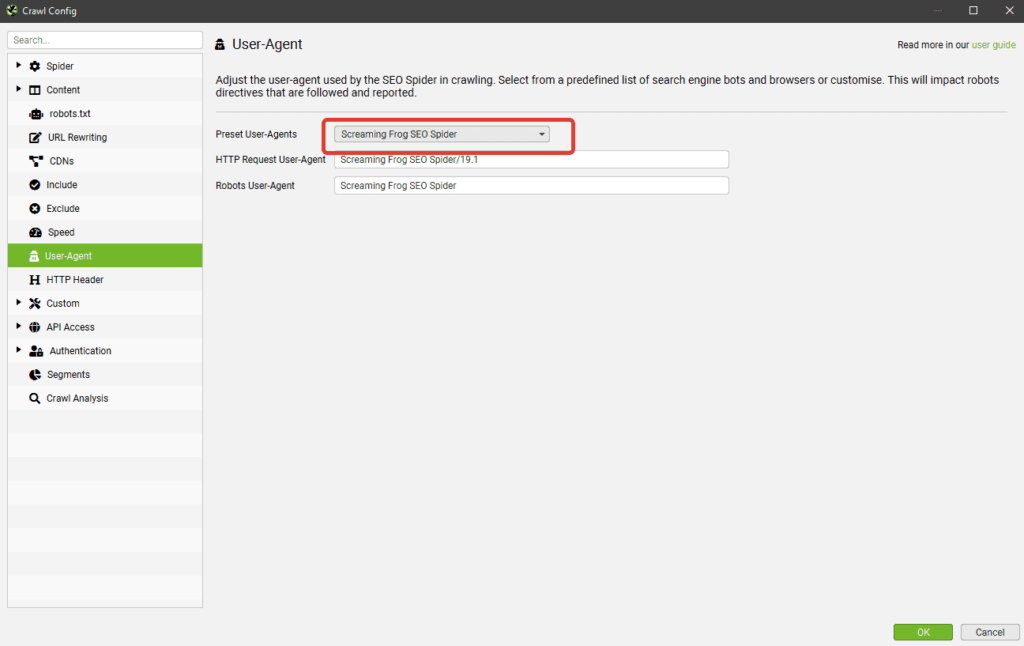

Настраиваем User Agent

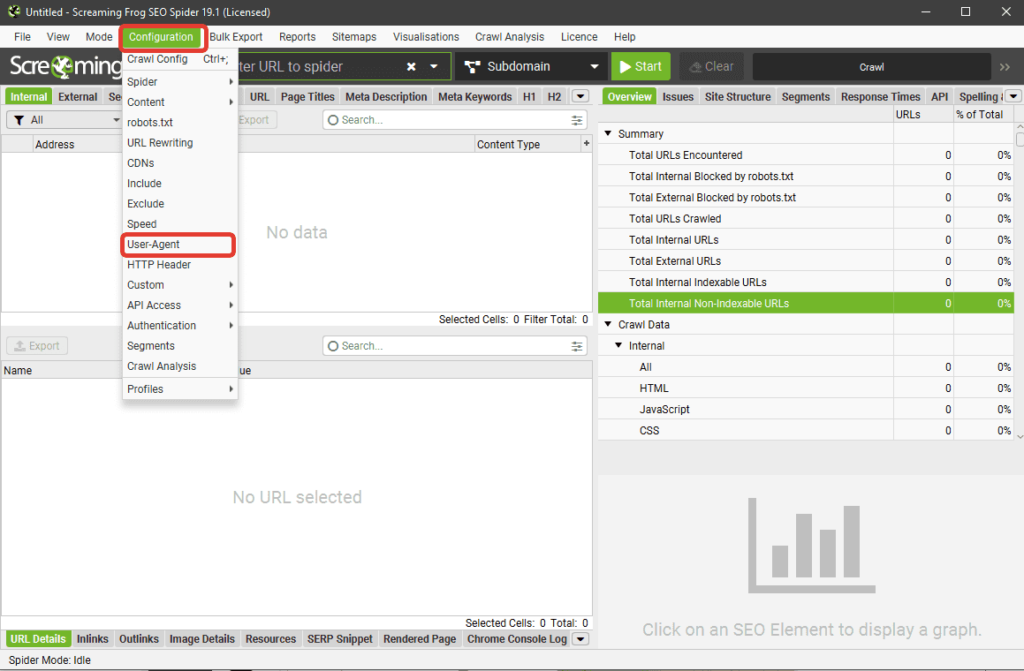

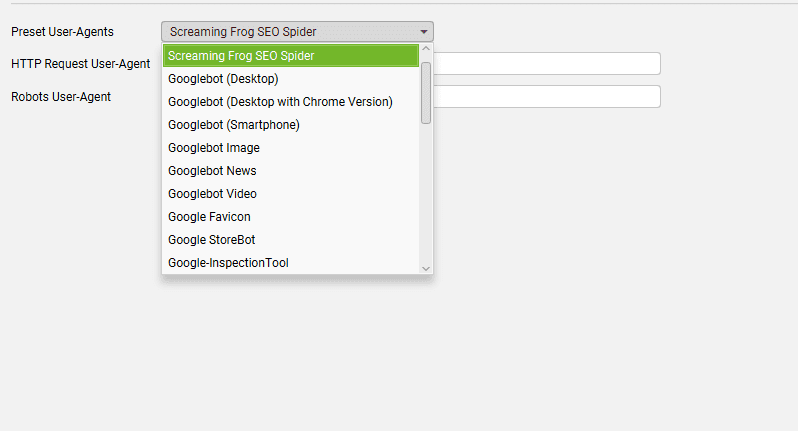

Теперь переходим во вкладку Configurations в верхнем меню и кликаем по пункту User-Agent. Его необходимо настроить для парсинга сайтов.

В выпадающем списке можно выбрать любого юзер-агента – к примеру, Гугл-бот для смартфонов особенно удобен. Screaming Frog в этом случае маскируется под бота, и сайт отдает всю нужную информацию без блокировки.

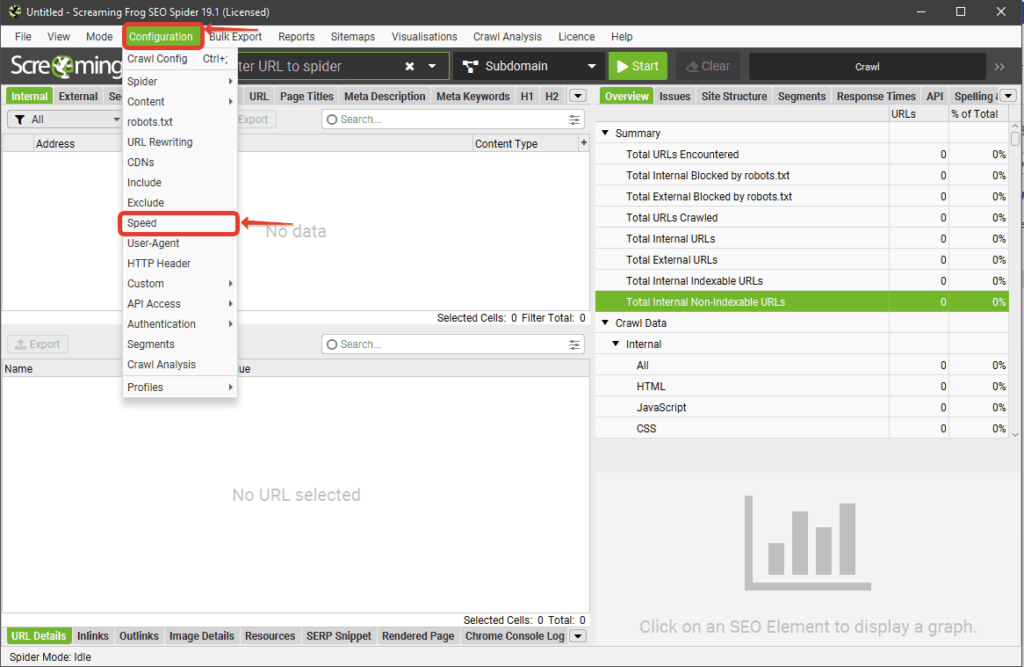

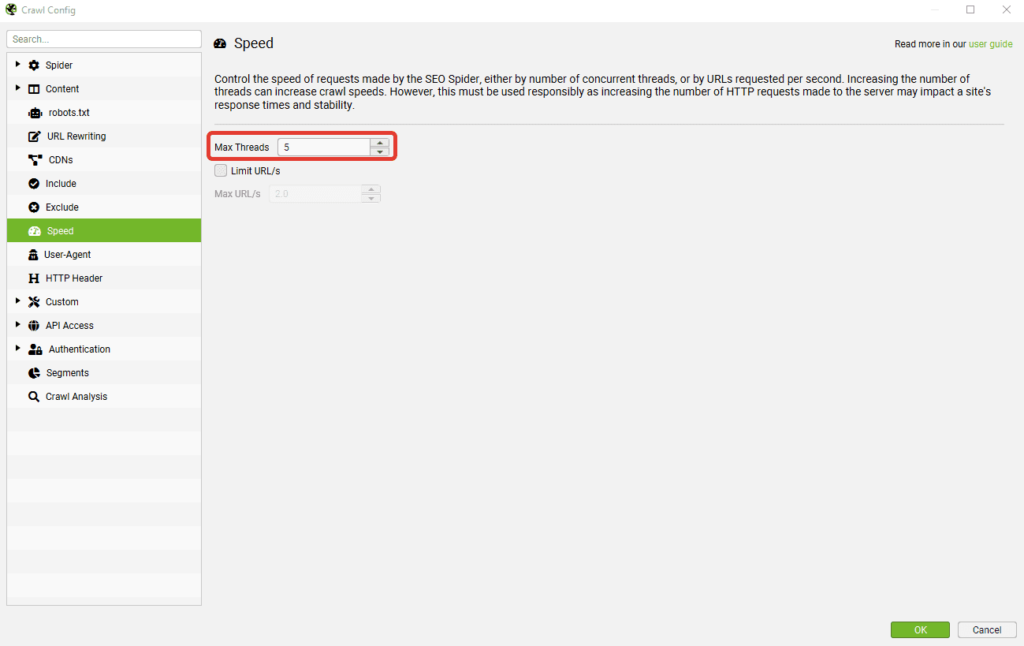

Настройка скорости парсинга

После настройки юзер-агента возвращаемся в Configurations и выбираем пункт Speed. Здесь можно задать до 20 потоков. Однако для не слишком мощного компьютера может быть достаточно и пяти.

Настраиваем выборку разделов для парсинга

Далее нам может потребоваться задать настройки парсинга. Если нужен технический аудит всего сайта, делать это необязательно. Однако если в приоритете анализ каких-то определенных разделов, сузить поиск все же стоит.

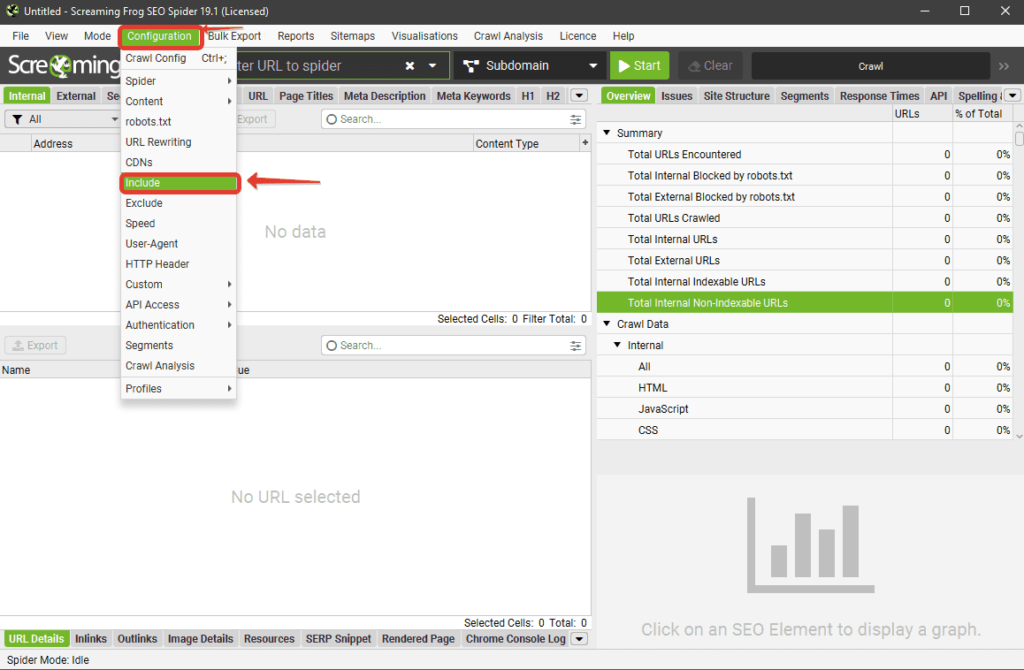

Делается это через вкладку Configurations, пункт меню – Include.

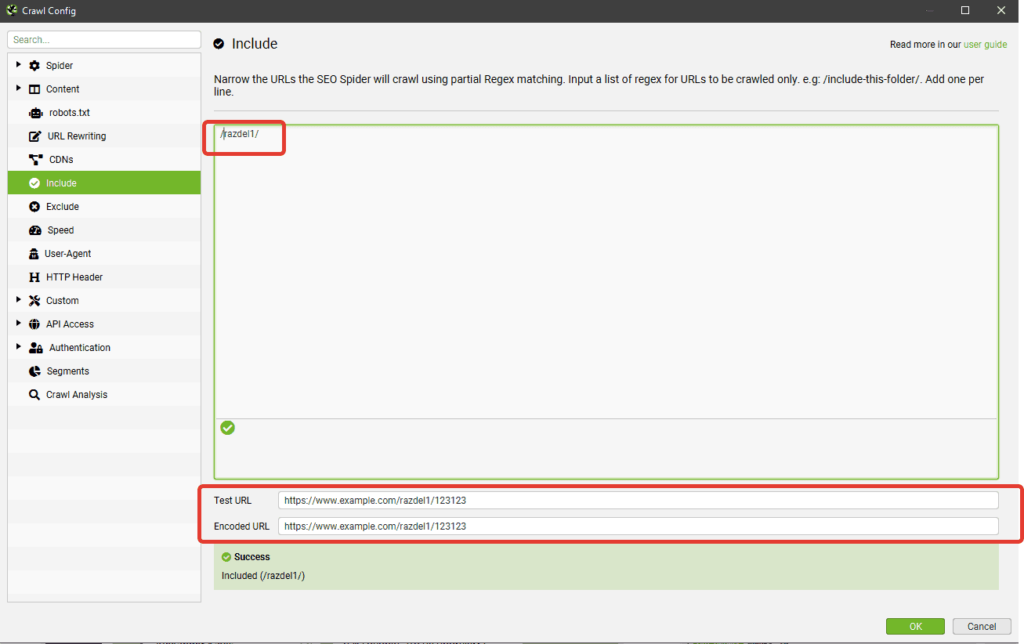

Здесь мы можем ввести данные раздела или страницы товара, чтобы посмотреть, будет ли он попадать в парсинг. Например, вводим «/razdel1» и проверяем будет ли при этом сканироваться интересующий нас URL «https://www.example.com/razdel1/123123».

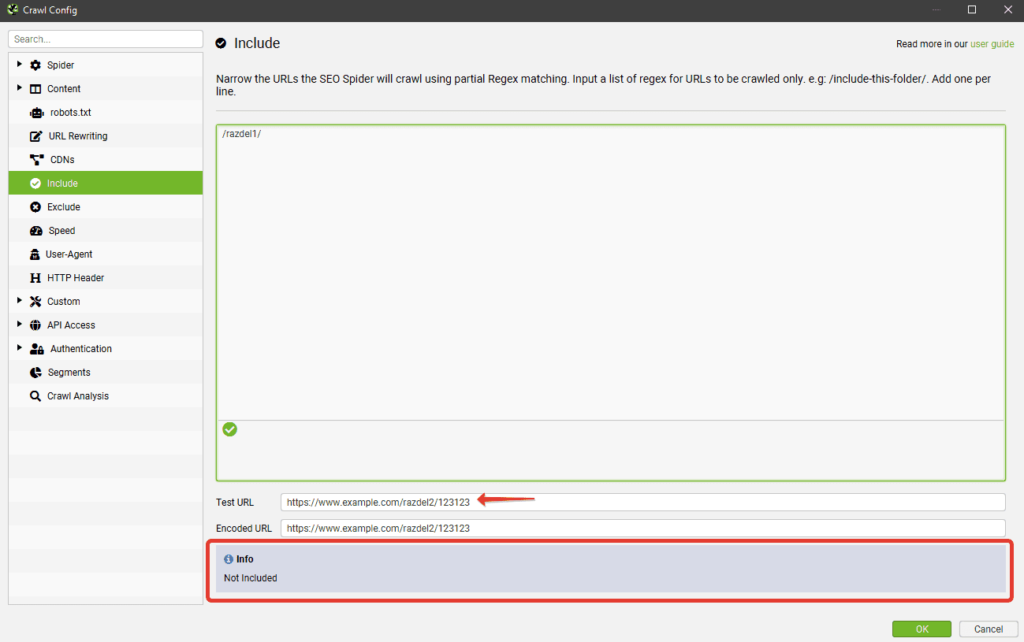

Если же URL не попадает под сканирование, то будет указана следующая проблема.

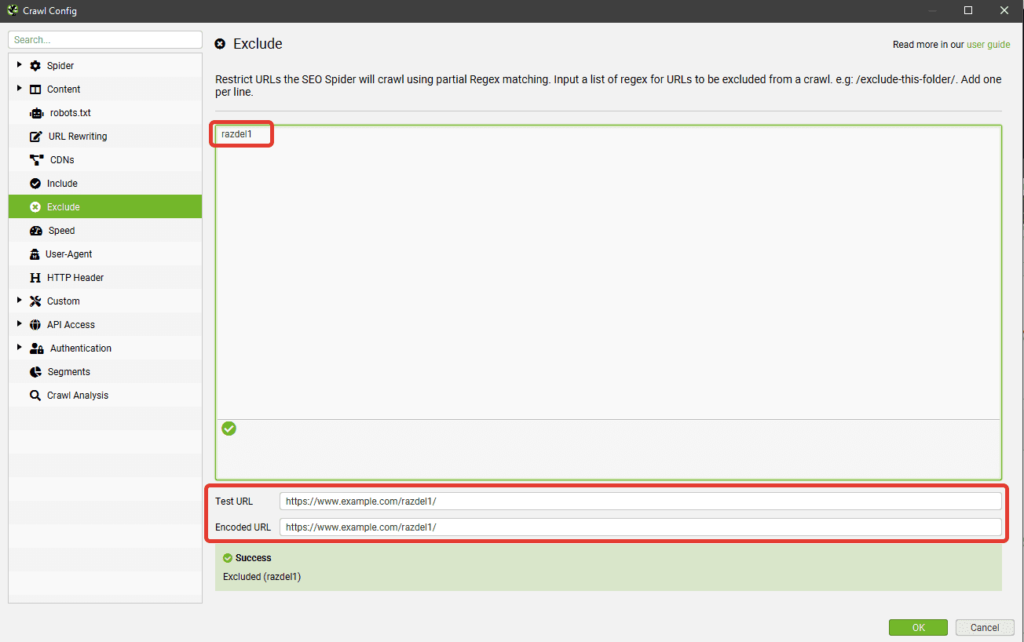

Если, напротив, требуется исключить какой-либо раздел из парсинга, действуем так же, но через пункт Exclude.

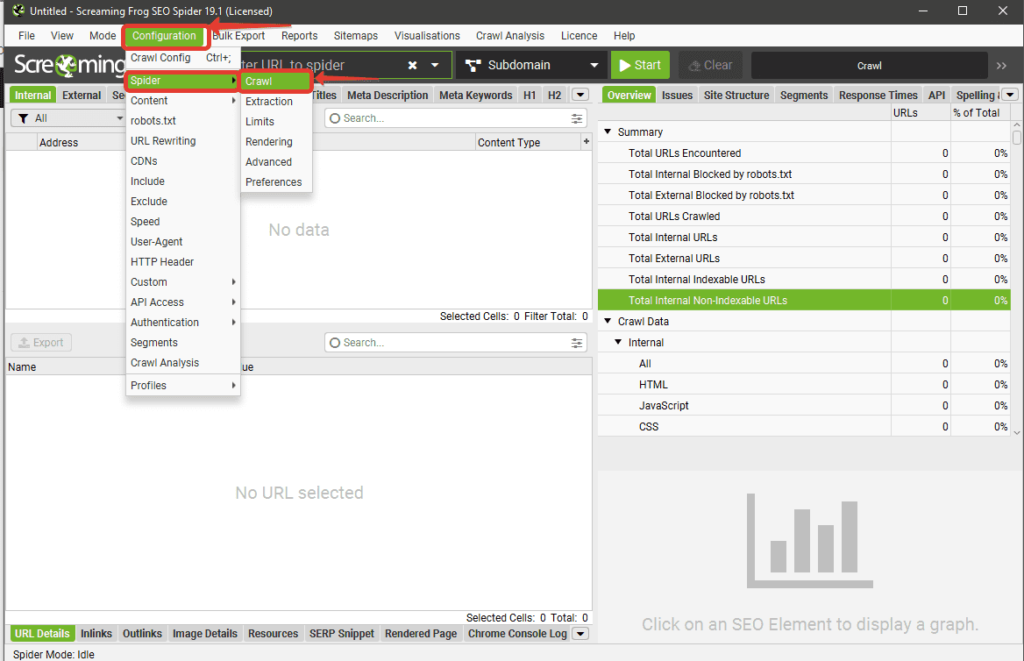

Настраиваем Spider Crawl

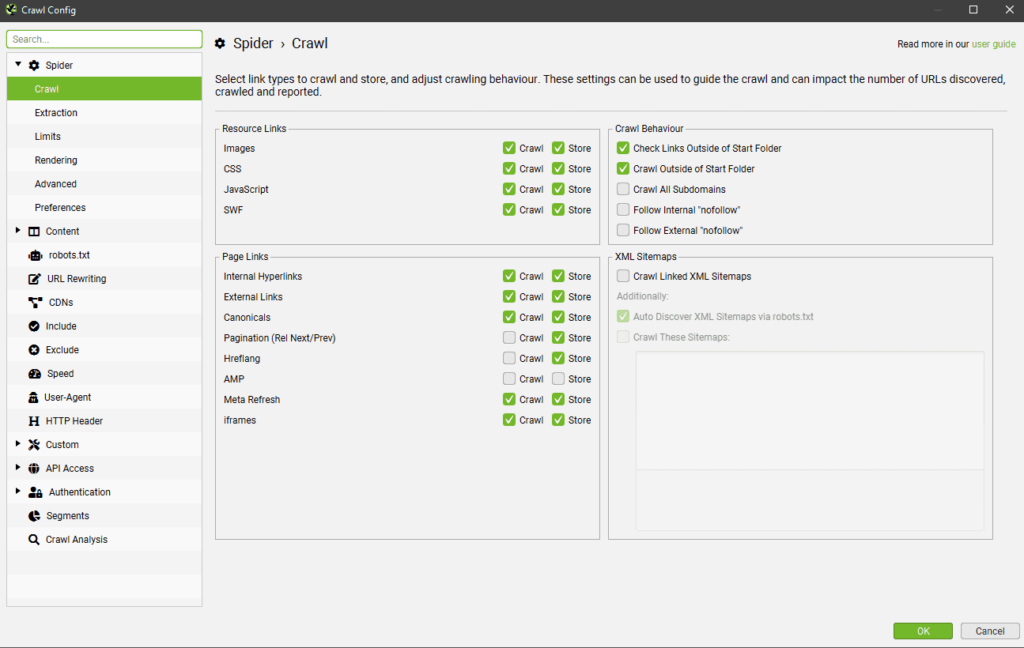

На этом этапе мы выбираем тип сканирования данных. Для этого переходим в Configurations, выбираем пункт Spider и кликаем по Crawl в выпадающем списке.

Далее устанавливаем флажки напротив данных, которые нам нужны и отключаем парсинг ненужных типов данных. Если сайт небольшой, эти настройки можно оставить по умолчанию – в этом случае лучше просканировать все.

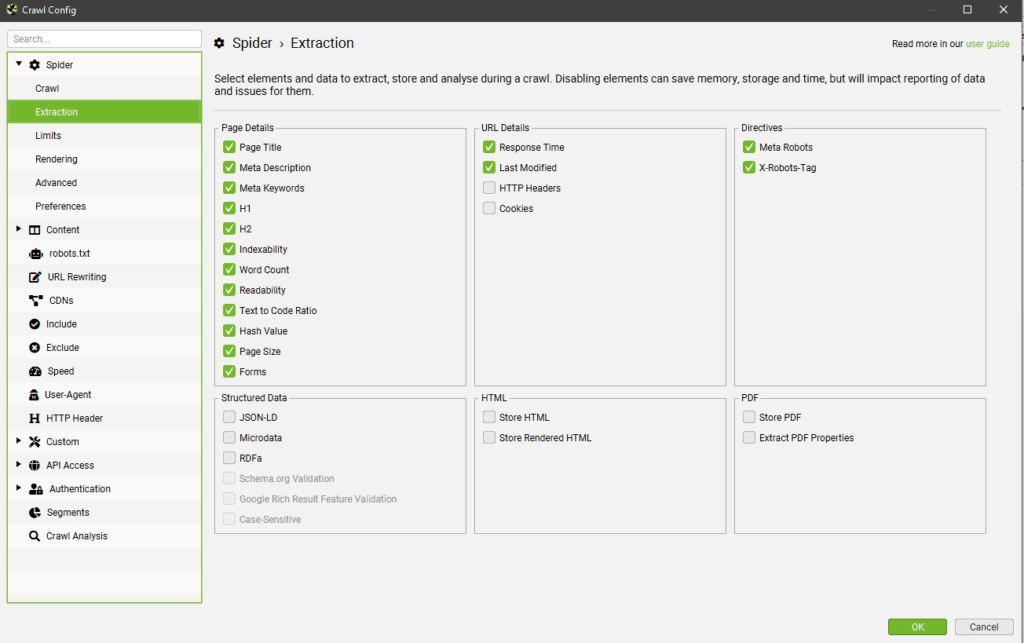

После этого переходим в раздел Extraction здесь же и выбираем, что именно будет сканироваться – тайтлы, дескрипшены, структурированные данные и так далее. Все ненужное можно исключить.

Подключаем доступ к сайту через аккаунт Google

Теперь снова возвращаемся в Configurations, пункт API Access. Здесь выбираем Google Search Console. Это требуется для поиска проблемных страниц, на которые не ведет ни одна ссылка – так называемых Orphan Pages или Orphan URLs. В этом случае их можно быстро найти и сделать необходимую перелинковку.

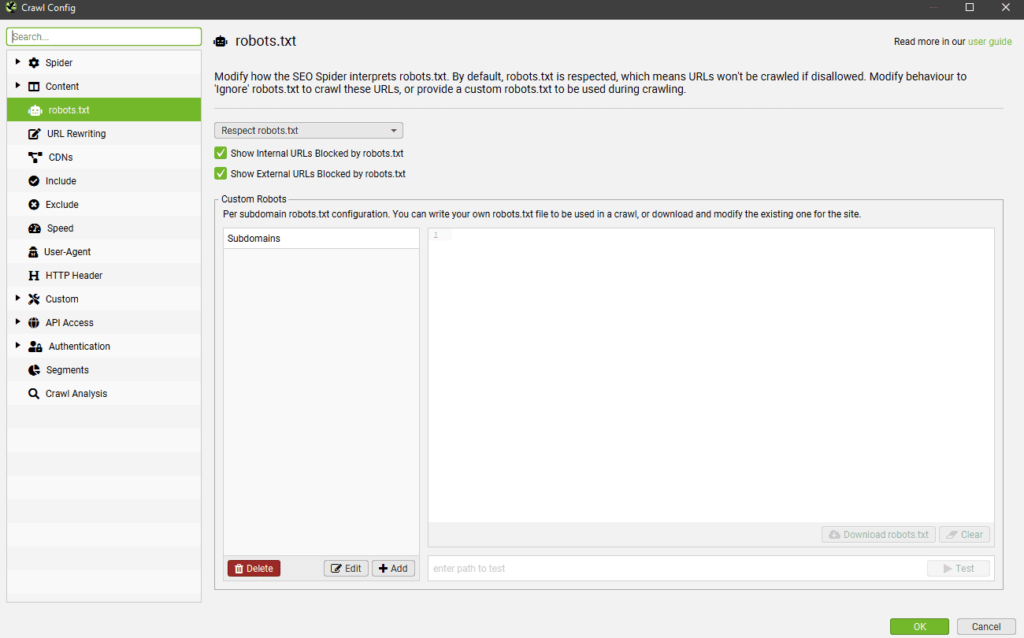

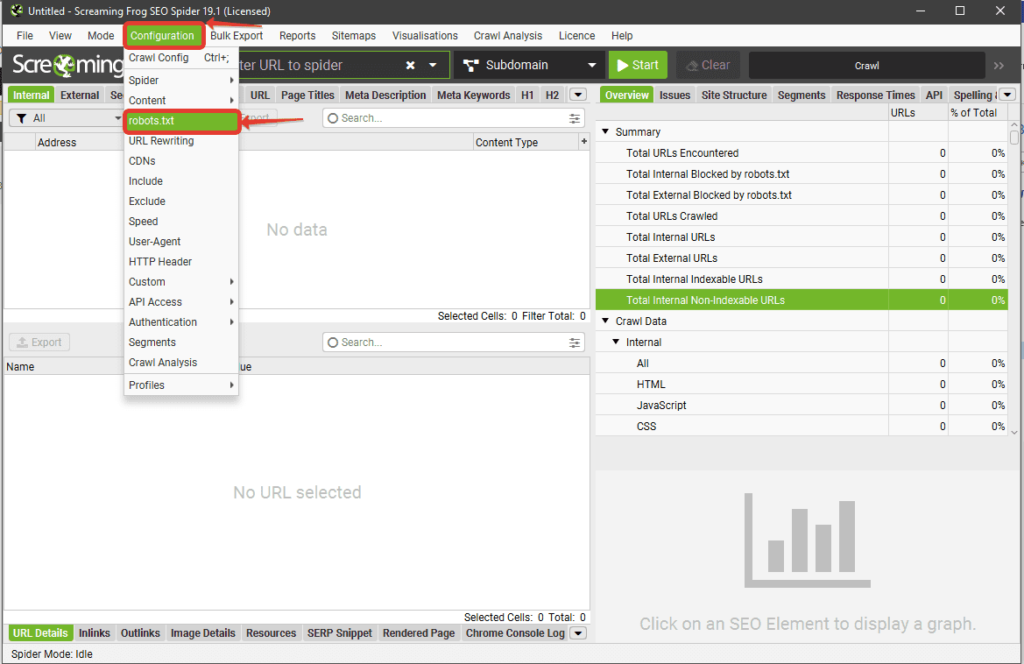

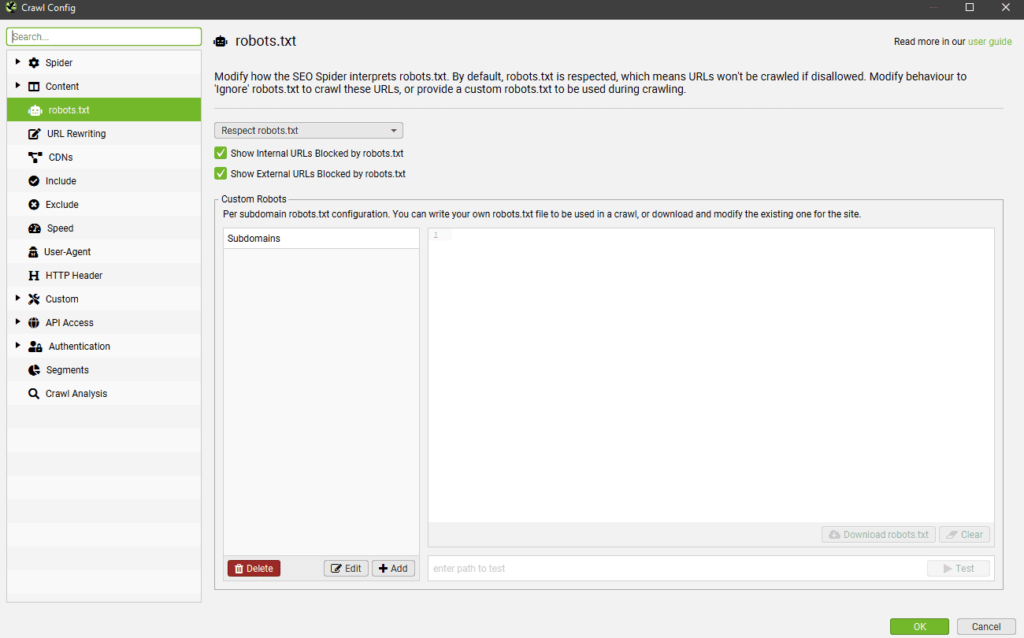

Настраиваем работу с robots.txt

Теперь мы еще раз переходим в меню Configuration и выбираем соответствующий пункт. Далее мы выбираем, в каком режиме работать с robots.txt:

- Ignore – если необходимо видеть весь сайт целиком.

- Respect – с участием функционала robots.txt.

- Ignore robots.txt but report status – если нужны данные о смене статуса страниц.

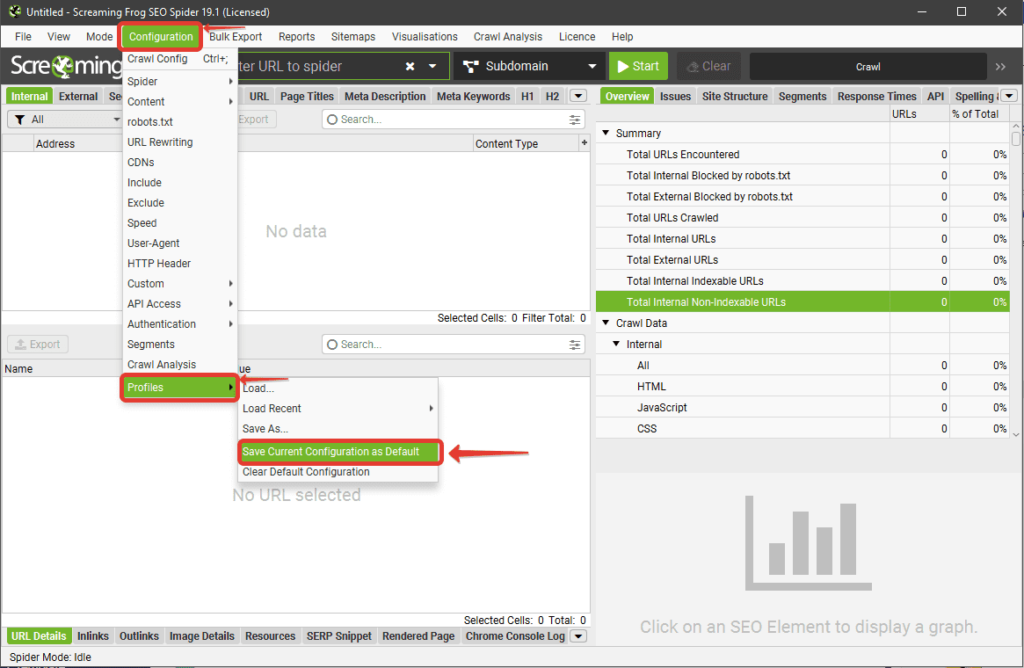

Сохраняем настройки как базовые в Screaming Frog

Если все указанные выше настройки требуются вам постоянно, стоит сохранить их соответствующим образом, поскольку Screaming Frog всегда открывается с базовых параметров. Для этого переходим в пункт Profile в меню Configuration и выбираем Save Current Configuration as Default («сохранить текущие настройки по умолчанию»).

Здесь же вы можете создать несколько соответствующих профилей для различных задач и просто менять пакет настроек под приоритетную.

Подписывайтесь на наш канал в Яндекс.Дзен

Подписывайтесь на наш Telegram-канал

Подписывайтесь на наш Youtube-канал

Подписывайтесь на нашу группу ВКонтакте

(20 оценок, среднее: 3,80 из 5)

(20 оценок, среднее: 3,80 из 5)